今天根据B站播放量最高的一个Python爬虫教学视频学习了一下,视频中的案例是爬取豆瓣电影TOP250,学习过程中遇到一些问题特此随笔作为记录。

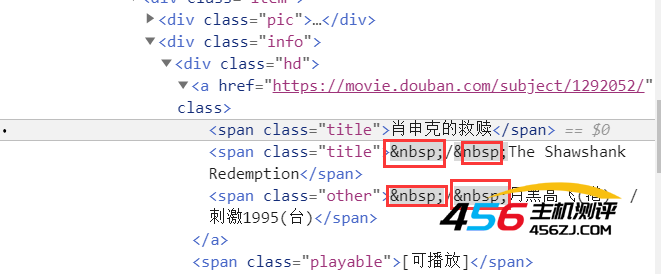

我出现问题的地方对应部分网站源码如下图:

由于没有学过html的前端网页知识,所以图中的 代表什么意思也是上网查询后得知:它是html中的一个转义字符代表的是html中的硬空格,也就是在网页中显示的时候有一个 就显示一个空格。

这段源代码存储的是电影的外文名,我用正则匹配的时候将多余的 也涵盖了,所以最终结果多了一些奇怪的字符:\xa0

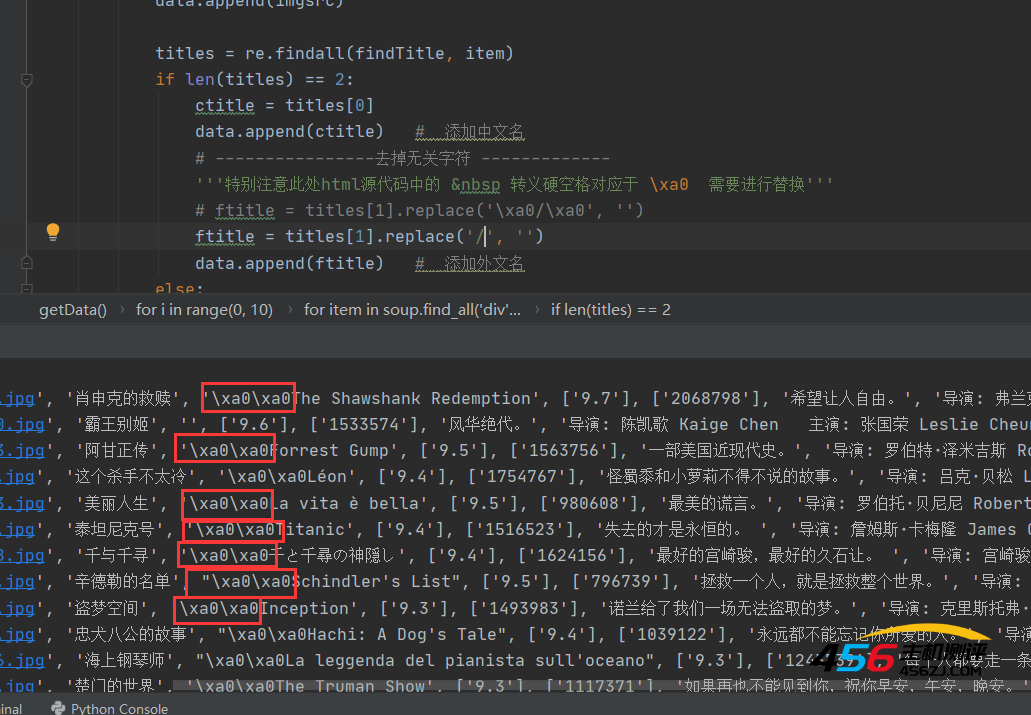

爬取结果如下图

那么怎么去除\xa0呢?

一开始我想着利用字符串的方法 :字符串.replace(' ', '', '要替换的字符串')来处理,结果并没有发生改变

后来查了查,才知道其实要用unicode编码来替换。

但其实 对应的unicode编码就是\xa0,所以直接替换\xa0为空白就可以了

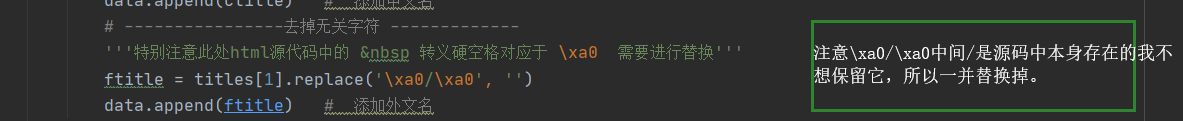

代码如下

代码中 titles[1] 就是我匹配出来的包含\xa0的电影外文名的字符串。

还查了网上的其他的资料,好像还有别的办法,没去研究,暂时不讨论了

- 海报

456主机测评

456主机测评